- KI kan foto’s beschrijven voor Instagramgebruikers met een visuele beperking

- Google heeft een nieuwe app gelanceerd die objecten aan blinden omschrijft

- Japans bedrijf lanceert slimme bril die geschreven tekst omzet in gesproken tekst

- De Dot Watch geeft informatie weer in braille

- Google lanceert nieuwe apps voor slechthorenden

- Onderzoekers van Columbia University creëren een systeem dat gedachten omzet in spraak

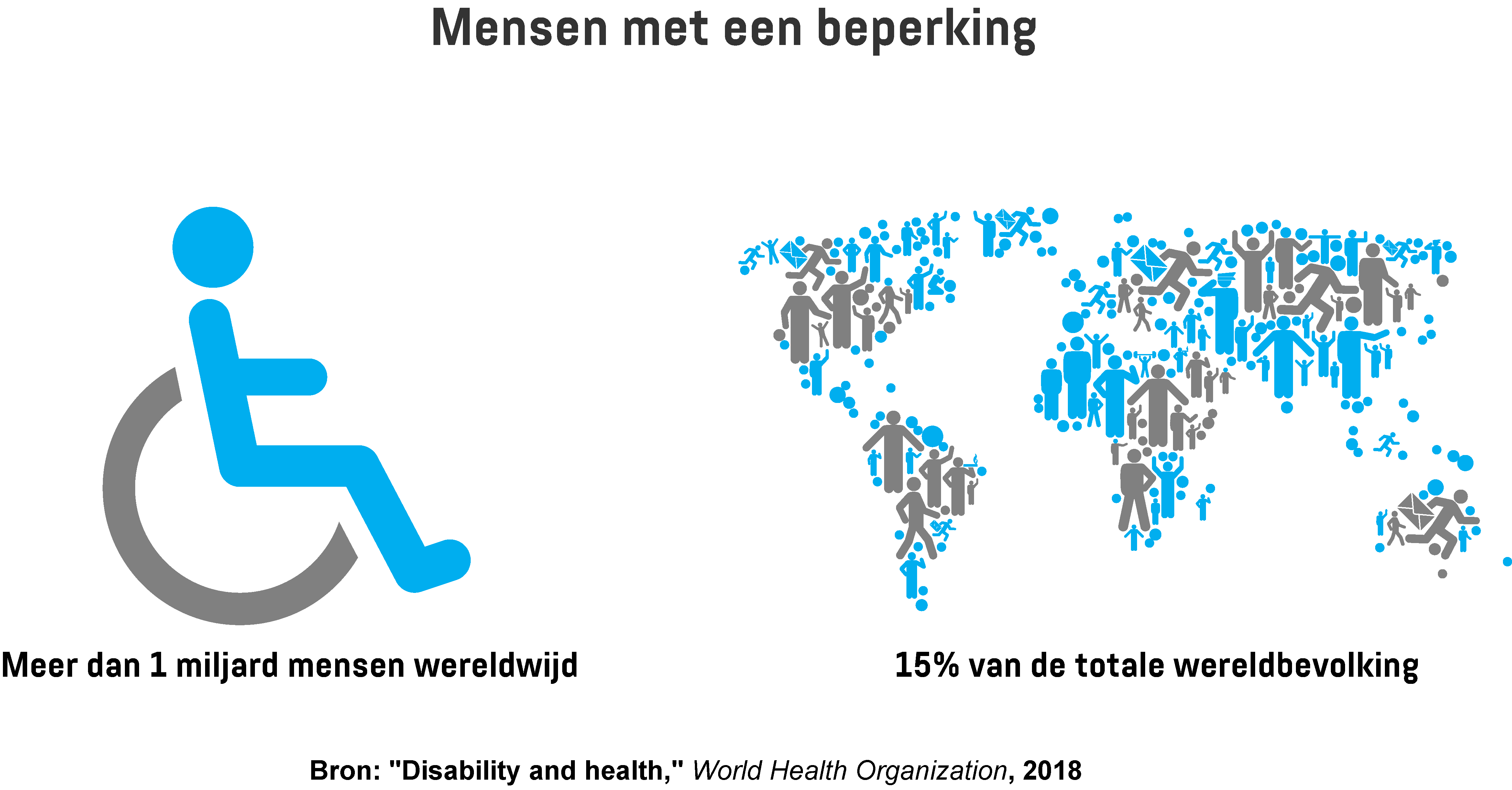

De Wereldgezondheidsorganisatie schat dat meer dan een miljard mensen wereldwijd een beperking hebben – dat is ongeveer 15 procent van de wereldbevolking. Naar verwachting zal dit percentage in de toekomst verder toenemen, onder meer als gevolg van de vergrijzing en het groeiende aantal mensen met chronische gezondheidsproblemen. Beperkingen kunnen een nadelige invloed hebben op de levenskwaliteit en tussen de 110 en 190 miljoen mensen boven de 15 jaar hebben naar schatting aanzienlijke problemen met functioneren in het dagelijks leven.

Een aantal bedrijven, waaronder techreuzen als Google, Facebook, Apple en Microsoft, maken steeds vaker gebruik van kunstmatige intelligentie, computervisie en spraakherkenningstechnologie om hulpmiddelen te ontwikkelen voor mensen met visuele, auditieve of lichamelijke beperkingen.

Hoewel techbedrijven vaak aangeven dat het ontwikkelen van dit soort hulpmiddelen altruïstisch gemotiveerd is, spelen er uiteraard ook andere factoren mee. Bedrijven streven voortdurend naar meer winst en meer klanten en dat is moeilijker te realiseren wanneer ze producten ontwikkelen die niet voor iedereen bruikbaar zijn. Daarmee zien ze namelijk een aanzienlijk deel van de bevolking over het hoofd. De recente opkomst van spraakgestuurde luidsprekers en het toegenomen gebruik van ondertiteling op websites en social media zijn belangrijke ontwikkelingen waardoor bijvoorbeeld internetdiensten voor veel meer mensen toegankelijk worden. Maar er moet nog veel meer gedaan worden om ervoor te zorgen dat mensen met een beperking van net zoveel dingen kunnen genieten als mensen zonder beperkingen.

KI kan foto’s beschrijven voor Instagramgebruikers met een visuele beperking

Instagram is een goed voorbeeld van de problemen waarmee mensen met een beperking op het internet te maken hebben. Het populaire social mediaplatform heeft meer dan een miljard actieve maandelijkse gebruikers, maar omdat het platform visueel van aard is, is het niet geschikt voor mensen met een visuele beperking. Omdat Instagram daar verandering in wil brengen heeft het onlangs de lancering van een nieuwe functie aangekondigd. Hiermee moet het platform toegankelijker worden voor de 253 miljoen mensen in de wereld die blind zijn of kampen met een matige tot ernstige visuele beperking.

Deze mensen maken vaak gebruik van schermlezers om door internetcontent te browsen. Het is een stukje software dat afbeeldingen op een scherm beschrijft door speciale omschrijvingen voor te lezen in de vorm van alternatieve tekst, ook wel ‘alt-tekst’ genoemd. Helaas is deze alternatieve tekst vaak niet beschikbaar. Instagram heeft echter een manier gevonden om dit probleem met behulp van kunstmatige intelligentie op te lossen.

Vanaf nu, als gebruikers door hun feed, de Explore-pagina of het profiel van een andere gebruiker scrollen, kan de herkenningstechnologie van Instagram automatisch herkennen wat er op een foto staat en dit hardop omschrijven als er geen alternatieve tekst beschikbaar is. Bovendien kunnen alle gebruikers via de geavanceerde instellingen hun eigen aangepaste beschrijvingen toevoegen aan foto’s die ze uploaden. Deze aangepaste beschrijvingen zijn alleen zichtbaar voor schermlezers en bieden mensen met een visuele beperking een vlotte, efficiënte Instagram-ervaring.

Google heeft een nieuwe app gelanceerd die objecten aan blinden omschrijft

Google heeft onlangs een app uitgebracht die mensen met een visuele beperking, zelfs buiten Instagram, ondersteuning kan bieden. De app heet Lookout en maakt gebruik van kunstmatige intelligentie om objecten te identificeren en te beschrijven. De app werkt op basis van dezelfde technologie als die van Google Lens en biedt gebruikers meer informatie over de omgeving of objecten om hen heen.

De app beschikt over drie verschillende standen: Explore, Shopping en Quick Read. De Explore-stand is voor het herkennen van alledaagse objecten, zoals een lamp, een bord, een zak chips, enzovoort. Met de Shopping-stand krijg je assistentie in winkels – zo helpt de app bijvoorbeeld met het scannen van barcodes en het voorlezen van prijzen en productomschrijvingen. De Quick Read-modus is bedoeld om bijvoorbeeld teksten van reclame- of verkeersborden voor te lezen – eigenlijk elke tekst waar de camera op gericht is. Met Lookout hoef je alleen je camera (ergens op) te richten en vervolgens hoor je wat er zich om je heen afspeelt. Google Lookout biedt mensen met een visuele beperking dus een ongekende mate van onafhankelijkheid, ongeacht de situatie waarin ze zich bevinden.

Helaas is de app voorlopig alleen nog beschikbaar voor eigenaren van Google Pixel-apparaten in de Verenigde Staten. Een ander probleem is dat het alleen nog in het Engels beschikbaar is. Bovendien waarschuwt het bedrijf dat de app op dit moment nog niet 100 procent nauwkeurig is. Maar ondanks deze nadelen zou de Lookout-app een enorm positieve impact kunnen hebben op de levenskwaliteit van mensen met een visuele beperking. Google heeft bekendgemaakt de app te willen verbeteren waarna deze voor meerdere toestellen, landen en platformen beschikbaar zal worden.

Japans bedrijf lanceert slimme bril die geschreven tekst omzet in gesproken tekst

De slimme Oton Glass-bril is speciaal ontworpen voor mensen met een visuele beperking en helpt hen geschreven tekst in audio om te zetten. De bril is uitgerust met twee kleine camera’s en een oortje. Eén camera is naar binnen gericht en volgt de oogbewegingen van de gebruiker om te detecteren wanneer deze knipperen. De tweede camera maakt opnames van tekst. Wanneer de gebruiker de bril op een stukje tekst richt dat hij of zij wil ‘lezen’ en vervolgens met zijn of haar ogen knippert, maakt de camera een foto van de tekst en uploadt deze naar een speciaal Raspberry Pi-cloudsysteem. Met behulp van optische tekenherkenningstechnologie wordt de foto geanalyseerd en omgezet in geluid, dat vervolgens via het oortje wordt afgespeeld.

Mocht het systeem de tekst niet kunnen ontcijferen, dan wordt het doorgestuurd naar een externe medewerker die het probleem oplost. Het Japanse concept heeft kritiek gekregen van mensen die beweren dat het niet beter is dan Google Translate, dat in feite hetzelfde doet. Een van de verschillen met Google Translate is echter dat de gebruiker van Oton Glass zijn of haar telefoon niet hoeft aan te zetten, de app op te starten en de tekst te scannen om deze te kunnen lezen. Het enige wat de gebruiker hoeft te doen is met zijn ogen knipperen.

De Dot Watch geeft informatie weer in braille

De Dot Watch van het Zuid-Koreaanse bedrijf Dot is ’s werelds eerste smartwatch voor mensen met een visuele beperking. Met de Dot Watch wil het bedrijf deze doelgroep meer zelfstandigheid bieden. Het horloge heeft een minimalistisch ontwerp met een bewegend toetsenbord dat informatie in real-time braille weergeeft. Naast de primaire functie ervan – het weergeven van de tijd en de datum – kan de Dot Watch bovendien aan een speciale app gekoppeld worden, waardoor het ook oproepen, tekstberichten, weerberichten, verkeersinformatie en social media-notificaties kan weergeven.

Het horloge is gemaakt van zilveraluminium en bevat vier elektromagnetische actuators waarmee informatie in de vorm van textuurstippen weergegeven wordt. De stippen stijgen en dalen automatisch om letters en cijfers in braille te spellen, maar in tegenstelling tot andere braille-displays die één regel tegelijk lezen, heeft de Dot Watch een aanraakgevoelig actief scherm dat de braillevorming naar de volgende ‘vertaling’ doorschakelt zodra de gebruiker zijn vinger van de laatste punt in een zin haalt. Gebruikers kunnen ook handmatig tussen berichten switchen door op de bovenkant van het horloge te tikken of de knopjes aan de zijkant te gebruiken. Helaas ondersteunt de software momenteel alleen Engelse en Koreaanse braille, maar het bedrijf hoopt in de nabije toekomst ook ondersteuning te bieden voor andere talen, waaronder Japans, Duits, Frans, Spaans, Arabisch, Italiaans, Chinees en Hindoestaans.

Google lanceert nieuwe apps voor slechthorenden

Hoewel er allerlei producten zijn voor mensen met een visuele beperking, kan hetzelfde niet worden gezegd voor mensen met auditieve beperkingen. Er wordt geschat dat er meer dan 466 miljoen mensen wereldwijd kampen met een auditieve beperking. Vooral voor mensen die geen gebarentaal kennen is sociale communicatie soms erg moeilijk. Daarom heeft Google onlangs de lancering aangekondigd van twee nieuwe Android-apps die zijn ontworpen om dove of slechthorende mensen te helpen.

Live Transcribe is, zoals de naam al doet vermoeden, een transcriptie-app die automatisch en in real time vertaalt wat mensen in de buurt van de gebruiker zeggen. De app heeft ook een volume-indicator die het niveau van het achtergrondgeluid in de ruimte aangeeft en laat weten wanneer de microfoon dichterbij moet komen of wanneer de gebruiker zelf harder moeten praten. Wanneer het omgevingsgeluid te hard is waardoor de app niet werkt, kan de gebruiker een bericht typen. De app beschikt ook over haptische feedback en laat de telefoon trillen om de gebruiker te laten weten dat er tegen hem of haar gesproken wordt. De app ondersteunt meer dan 70 verschillende talen en dialecten. De gebruiker kan primaire en secundaire talen selecteren en eenvoudig tussen deze talen heen en weer schakelen. Google werkt bovendien aan een automatische taalherkenningsfunctie, wat het gebruiksgemak nog verder zal verbeteren. Een minpuntje is dat de app gebruikmaakt van de Google Cloud-spraak-API, wat betekent dat de app een internetverbinding nodig heeft waardoor de bruikbaarheid van de app beperkt wordt.

De Sound Amplifier geluidsversterker fungeert als een soort gehoorapparaat dat slechthorenden door middel van een hoofdtelefoon helpt gesprekken in lawaaierige omgevingen beter te verstaan. De app beschikt over een aantal schuifregelaars waarmee gebruikers omgevingsgeluiden als het ware kunnen wegfilteren en de stemmen van mensen om hen heen kunnen versterken. In tegenstelling tot Live Transcribe werkt de Sound Amplifier-app wel zonder internetverbinding en de geluidsverwerking wordt ter plekke uitgevoerd.

Onderzoekers van Columbia University creëren een systeem dat gedachten omzet in spraak

Een andere innovatie die een levensveranderende impact kan hebben op het leven van mensen met beperkte of geen spraakvaardigheden is onlangs ontwikkeld door neuro-ingenieurs aan Columbia University. Zij hebben een systeem gecreëerd waarmee je gedachten kunt vertalen naar begrijpelijke, herkenbare spraak. Het systeem monitort iemands hersenactiviteit met behulp van kunstmatige intelligentie en spraaksynthesizers en reproduceert de woorden die ze horen met een enorme mate van helderheid. “Onze stemmen helpen ons contact te maken met onze vrienden, familie en de wereld om ons heen. Het verlies van de kracht van je stem als gevolg van letsel of ziekte is dan ook verschrikkelijk”, zegt Nima Mesgarani, hoofdonderzoeker van Mortimer B. Zuckerman Mind Brain Behavior Institute van Columbia University. “We hebben nu een potentiële manier om die kracht te herstellen. We hebben aangetoond dat de gedachten van deze mensen met de juiste technologie kunnen worden gedecodeerd en door iedere luisteraar begrepen”.

Het systeem is opgebouwd rond een vocoder, een computeralgoritme dat menselijke spraak synthetiseert. De onderzoekers hebben de vocoder getraind om hersenactiviteit te interpreteren door data over neurale patronen van vijf epilepsiepatiënten in te voeren. De patiënten waren al ingepland voor hersenchirurgie en gingen akkoord met het plaatsen van elektroden op hun hersenen. Eerst werden de patiënten gevraagd om te luisteren naar een aantal gesproken zinnen terwijl de onderzoekers hun hersenactiviteit registreerden. Deze data werd vervolgens gebruikt om de vocoder te trainen. Daarna vroegen de onderzoekers de patiënten te luisteren naar iemand die van nu tot negen telde. De hersensignalen werden wederom geregistreerd en vervolgens werd de vocoder geïnstrueerd deze signalen om te zetten in geluid. Daarna werden de geluiden door neurale netwerken geanalyseerd en ‘opgeschoond’. Een robotachtige stem wist de geluiden die de patiënten oorspronkelijk gehoord hadden uiteindelijk met 75 procent nauwkeurigheid te herhalen.

Het enige nadeel is dat het systeem momenteel alleen gedachten kan vertalen die ontstaan wanneer iemand naar een pratende persoon luistert. In de toekomst hopen de onderzoekers het systeem te kunnen trainen met woorden die de persoon zich voorstelt. “Dit zou een game changer zijn”, zegt Mesgarani. “Het zou iedereen die zijn spraakvermogen door letsel of ziekte kwijtgeraakt is de kans geven weer contact te maken met de wereld om hem of haar heen.”

Bedrijven over de hele wereld maken steeds vaker gebruik van technologieën als kunstmatige intelligentie, computervisie en stemherkenning om hulpmiddelen te ontwikkelen die mensen met een beperking kunnen helpen – een welkome trend die een belangrijke bijdrage kan leveren aan de levenskwaliteit van mensen met een visuele, auditieve of andere beperking.

Share via: