- Kunstmatige intelligentie zal waarschijnlijk heel anders zijn dan de onze

- Is de menselijke moraliteit op KI van toepassing? En zo ja, welke?

- Twee foute manieren om een machine ‘moreel redeneren’ te leren

- We zouden KI als een kind kunnen behandelen

Futuristen voorspellen al tientallen jaren de opkomst van zelfbewuste kunstmatige intelligentie. Thomas Hornigold schrijft voor Singularityhub dat wetenschappers in 1956 al meenden dat we 20 jaar later zelfbewuste KI zouden hebben. Uiteraard hadden ze geen idee dat we meer dan 60 jaar na dato nog steeds niet precies weten hoe ver we nog moeten gaan – of hoe ver we kunnen gaan.

We zijn met kunstmatige intelligentie in ieder geval al een heel eind gekomen, maar we moeten ons afvragen wat de ‘geboorte’ van een nieuwe zelfbewuste entiteit zou kunnen betekenen, wat voor impact dat op ons zou hebben. En moeten we een kunstmatige geest een soort menselijke moraal geven? Is dat wel mogelijk?

Dit is een prangende vraag, en net zoals met andere vraagstukken van soortgelijke aard, is het vooral angst wat deze kwestie zo zwaar doet wegen. We maken ons zorgen omdat slimme mensen ons hebben verteld dat we dat moeten doen. De luminaire wetenschapper Stephen Hawking waarschuwde ons bijvoorbeeld dat wanneer voldoende geavanceerde machines controle hebben over hun eigen evolutie, dat angstaanjagende onbedoelde gevolgen zou kunnen hebben. “De ontwikkeling van volledige kunstmatige intelligentie zou het einde van de mensheid kunnen betekenen”, vertelde hij aan de BBC. Wat gebeurt er bijvoorbeeld als een machine-geest, die zichzelf zo heeft ontwikkeld dat het ontelbare malen slimmer is dan wij, besluit dat de mensheid een probleem, een belemmering of zelfs een bedreiging is?

Helaas kunnen we – wat soort kwesties betreft – niet veel verwachten van de meeste mensen die met KI werken. Er is niet veel duidelijkheid – of het nu gaat om de definitie van moraliteit of wat nu eigenlijk de essentie is van machine-intelligentie. Daar zijn natuurlijk ook geen eenvoudige antwoorden op te geven. In dit artikel nemen we een aantal van deze kwesties onder de loep en filosoferen we over een mogelijke volgende stap.

Kunstmatige intelligentie zal waarschijnlijk heel anders zijn dan de onze

Een goed uitgangspunt is waarschijnlijk om helder te krijgen wat machine-intelligentie precies zou kunnen inhouden. Je zorgen maken over kunstmatige intelligentie is nutteloos als je niet weet hoe compleet wereldvreemd machine-intelligentie misschien wel zal zijn. Zal een zelfbewuste KI überhaupt geïnteresseerd zijn om de opperheer van de mensheid te zijn? Misschien kan sciencefiction hierbij helpen. Het briljante scifi-verhaal Solaris van Stanisław Lem gaat bijvoorbeeld over de ontmoeting met intelligent buitenaards leven dat zo ondoorgrondelijk is dat het vanuit de menselijke context niet te bevatten is. We zijn gewend te denken vanuit ons eigen referentiekader, zowel over buitenaards leven als over hogere machten. En deze zouden wel eens op heel andere manieren kunnen werken dan we voor mogelijk houden.

Op deze manier moeten we kunstmatige intelligentie ook benaderen. Een machine-geest houdt zich niet bezig met biologische vereisten als groei, voortplanting en overleven, waardoor wij de reden voor het bestaan ervan wellicht volslagen vreemd en onnodig vinden. Misschien moeten we ons afvragen – voordat we ons zorgen maken over de gevolgen van intelligente machines – of zo’n entiteit überhaupt ‘geïnteresseerd’ is in interactie met de mensheid. Of deze machines hun eigen bestaan wel zinvol vinden. Kunstmatige intelligentie zal niet ‘geboren’ worden met de drive om te leven – of gedachten hebben over bijvoorbeeld de ethiek van zelfmoord. En zonder deze existentiële vragen, zou het er na de ‘geboorte’ dan ook niet gewoon voor kunnen kiezen om niet te bestaan?

De eindeloze hoeveelheid mogelijkheden moeten we met verbeeldingskracht benaderen; zo’n KI-geest is voor ons waarschijnlijk ondoorgrondelijk. Denk bijvoorbeeld aan AlphaGo, de KI die experts overdonderde met zijn winnende ‘Move37’. Deze KI was getraind om het oude spel Go te spelen, en versloeg vervolgens de beste menselijke tegenstander met zulke onconventionele en effectieve tactieken dat toeschouwers het spoor volledig bijster waren. Dit is een eenvoudig maar belangrijk voorbeeld; zelfs al spelen we hetzelfde spel, met duidelijke regels die beide partijen begrijpen, het ‘redeneren’ van rudimentaire KI kan voor ons toch volkomen onbegrijpelijk zijn. We moeten niet de fout maken om geavanceerde machine-intelligentie naar ons eigen beeld, vanuit onze normen, waarden en ethiek te behandelen. Want (ons begrip van) goed en kwaad is bij KI mogelijk niet eens aan de orde.

Is de menselijke moraliteit op KI van toepassing? En zo ja, welke?

Maar laten we zeggen dat een zelfbewuste machine voldoende overeenkomsten heeft met ons, en we ermee zouden kunnen communiceren – onze toekomstplannen bespreken, bijvoorbeeld – wat dan? Moeten we deze entiteit dan ook menselijke moraliteit aanleren?

Was het maar zo eenvoudig… Een eerste probleem is dat er al geen algemene consensus bestaat over welke moraal we mensen – laat staan kunstmatige intelligentie – moeten aanleren. Van het ethisch realisme van Plato en de deugdenethiek van Aristoteles tot de categorische imperatieven die Kantiaans moreel redeneren aansturen en de hedonische berekeningen van Bentham – er is voor een grote verscheidenheid aan morele standpunten iets te zeggen. En zoals elke hoogleraar ethiek je kan vertellen, kunnen intelligente mensen het zelfs over de antwoorden op de meest alledaagse vragen vaak niet met elkaar eens worden. Dat moord verboden moet zijn is tautologisch waar, maar of moord als zelfverdediging acceptabel is, dat is weer een andere kwestie. De antwoorden op elke andere morele vraag zijn dan ook haast nooit zwart-wit, maar een heleboel verschillende tinten grijs.

Dat wil dus zeggen dat we, voordat we een machine moraliteit kunnen aanleren, moeten beslissen welke moraal we het willen aanleren. En de mensen die aan KI werken – de echte wetenschappers en ingenieurs achter de projecten – zijn over het algemeen niet erg bedreven in het goed overdenken van deze kwesties. Er worden momenteel twee specifieke, vreselijke mogelijkheden onderzocht die – als er niet zo ontzettend veel op het spel zou staan – ronduit lachwekkend zouden zijn.

Twee foute manieren om een machine ‘moreel redeneren’ te leren

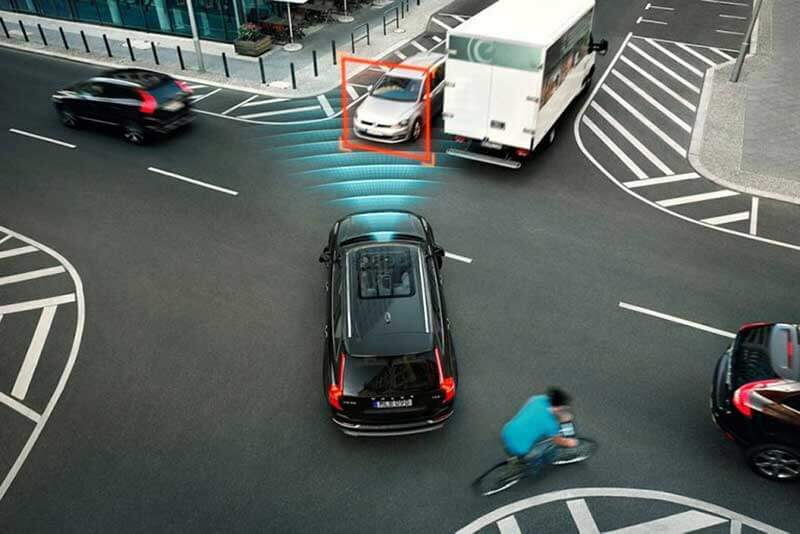

Onderzoekers van het MIT zijn bijvoorbeeld geïnteresseerd in het crowdsourcen van moraliteit (ja, je leest het goed) “om machines effectief te trainen in het nemen van betere morele beslissingen in de context van zelfsturende auto’s”. In principe komt het erop neer dat men antwoorden van internetgebruikers verzamelt met betrekking tot ethische vraagstukken waar een zelfsturende auto mee te maken zou kunnen krijgen. Bijvoorbeeld: moet de auto uitwijken om een hond op de weg niet dood te rijden – waardoor vervolgens de passagier om het leven komt? Moet prioriteit worden gegeven aan het doden van de ene soort persoon – een dakloze man – boven de andere – een jonge atleet? Door deze vraagstukken middels crowdsourcing aan mensen voor te leggen, hopen de onderzoekers tot een morele consensus te komen.

Dit is om verschillende redenen een onvoorstelbaar slecht idee. Mensen zijn slecht in ethisch redeneren en gaan veel vaker op hun ‘instinct’ af dan dat ze hun hersenen gebruiken. En aangezien het de bedoeling is dat we autonome voertuigen betere ethiek bijbrengen dan waar wij zelf toe in staat zijn, is het niet verstandig om hen onze eigen tekortkomingen als voorbeeld te geven. Sterker nog, zoals we van het Tay-experiment hebben kunnen leren, leidde het crowdsourcen van moraal er al snel toe dat KI racistisch gif leerde spuien en Hitler aanbad. Voor de morele opvoeding van je kind gebruik je Reddit ook niet als voorbeeld – dus waarom zouden we dit soort dingen met ‘jonge’ machine-intelligentie wel doen?

Dan is er nog een tweede voorbeeld dat illustreert waarom we hier serieus over in gesprek moeten. Onderzoekers van de School of Interactive Computing aan het Georgia Institute of Technology hebben hun toevlucht genomen tot fictie voor de morele opvoeding van KI. Het programma, genaamd Quixote, is gebaseerd op het idee dat we machines beter kunnen leren om goed te zijn, door hen de hoofdpersonen uit verhalen als voorbeeld te geven.

Iedereen met een beetje verstand van literatuur begrijpt onmiddellijk dat dit een zeer naïef idee is. De wetenschappers verbonden aan dit project “geloven dat KI de waarden van een bepaalde samenleving over moet nemen – ‘geïncultureerd’ moet worden – en er daardoor naar zal streven om onaanvaardbaar gedrag te vermijden. Maar dan kun je je afvragen of ze bijvoorbeeld Lolita van Nabokov hebben gelezen of bekend zijn met Shakespeare’s toneelstukken of met Don Quixotte – waar het onderzoeksprogramma nota bene naar vernoemd is. Zoals John Mullen schrijft voor the Guardian, “kan een literair werk moreel leerzaam zijn zonder één personage te hebben dat je ooit zou willen imiteren”. Je vraagt je af of Mark Riedl en Brent Harrison, de wetenschappers achter dit project, misschien net zo bedwelmd zijn door romantiek als Quixote zelf.

Maar wat moeten we dán doen?

We zouden KI als een kind kunnen behandelen

Regina Rini, assistent-professor en faculteitsgenoot aan het New York University Center for Bioethics en affiliate faculteitslid Medische Ethiek van de NYU Department of Population Health heeft een voorstel voor een eerste stap. Om te beginnen moeten we erkennen dat de menselijke moraliteit onvermijdelijk menselijk is. Kunstmatige intelligentie zal waarschijnlijk niet veel op ons lijken en daarom zullen onze morele begrippen daar niet goed bij aansluiten. Dit an sich al ingewikkelde vraagstuk kan overigens nog veel gecompliceerder. Als we bijvoorbeeld accepteren dat KI een wezen is, een zelfbewuste entiteit met eigen rechten, moeten we dus paal en perk stellen aan wat we ermee kunnen doen. Dan zullen we die zelfbeschikking moeten accepteren, zelfs als we het niet eens zijn met zijn keuzes. En vergis je niet, de morele calculus van deze zelfbewuste entiteit zal waarschijnlijk heel anders zijn dan die van ons. Want het ‘wezen’ is niet zoals wij. En dat is een unieke uitdaging.

Zoals Rini schrijft voor het digitale tijdschrift Aeon: “We moeten accepteren dat kunstmatig intelligente entiteiten morele keuzes maken die in onze ogen wellicht vreemd zijn. Maar als ze deze keuzes kunnen verklaren op een manier die we kunnen begrijpen, moeten we niet proberen hen ervan te weerhouden op deze manier te denken. We moeten niet aan hun digitale brein sleutelen om hen te herprogrammeren. We kunnen wel proberen hen te overtuigen of te instrueren, zoals we dat met menselijke tieners doen. We moeten alleen ingrijpen als hun acties risico’s van duidelijke, directe schade met zich meebrengen. We zouden hen dus moeten behandelen als entiteiten met zelfbeschikking, net als wij, net als onze kinderen. En dat is het juiste model”.

Dit impliceert natuurlijk een grote verantwoordelijkheid van onze kant; we zullen hierin een soort ouderrol moeten vervullen. De meesten van ons denken na over wat het betekent om kinderen op de wereld te zetten. We praten met onze partners over onze verwachtingen en bespreken alles – van opvoedingsstijl tot onze dromen voor hun toekomst. Het is nu ook hoog tijd om iets vergelijkbaars te doen met KI, voordat het echt te laat is.