- KI kan wat de hersenen zien omzetten in een gereconstrueerd beeld

- Hoe herdefinieer je hoe een diep neuraal netwerk ‘ziet’?

- De nauwkeurigheid van het KI-systeem is verbazingwekkend en behoorlijk creepy

- Privacyvoorstanders uiten hun bezorgdheid

We schreven onlangs over technologie waarmee de woorden die je denkt omgezet kunnen worden in spraak. Dat is een fascinerende ontwikkeling en wanneer deze indrukwekkende brain-computer interface (BCI) in de vorm van een non-invasieve wearable beschikbaar komt zijn er enorm veel toepassingsmogelijkheden. Een fantastische ontwikkeling voor mensen die niet kunnen praten of niet in staat zijn om bijvoorbeeld huishoudelijke apparaten te bedienen. De toekomst voor deze technologie ziet er dan ook veelbelovend uit.

Maar het onderzoek naar BCI’s is daar niet gestopt. We worden namelijk met de dag beter in het ontcijferen van hoe het menselijk brein werkt. Een veelbelovende methode is het gebruik van fMRI’s, een speciale vorm van magnetische resonantie beeldvorming die de bloedstroom in de hersenen detecteert. Hiermee kan een beeld dat de proefpersoon ziet – of zich herinnert – gereconstrueerd worden. Deze kunstmatig intelligente systemen maken gebruik van zeer slimme algoritmen die hersenactiviteit met verbazingwekkende nauwkeurigheid omzetten in beelden. En hoewel er voor deze technologie op dit moment nog geen echte toepassingen zijn, betekent het wel dat we de werking van de hersenen steeds beter gaan begrijpen. Geavanceerde versies van deze technologie zouden al snel kunnen leiden tot wearables die kunstenaars bijvoorbeeld in staat stellen om met hun gedachten te schilderen. Ook betekent deze doorbraak dat er in de toekomst effectievere behandelingen komen voor psychotische patiënten en dat we zelfs ’telepathische’ communicatiesystemen kunnen ontwikkelen.

KI kan wat de hersenen zien omzetten in een gereconstrueerd beeld

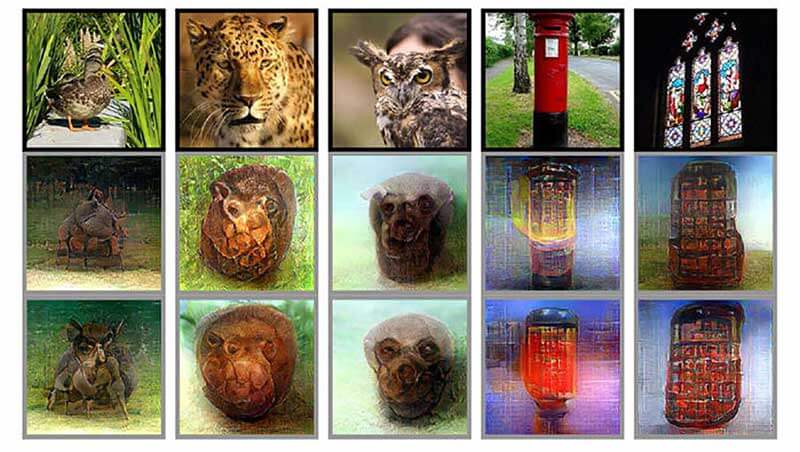

Een team van onderzoekers van Kyoto University onder leiding van Guohua Shen, waaronder Tomoyasu Horikawa, Kei Majima en Yukiyasu Kamitani, heeft gewerkt aan een systeem dat interpreteert wat de hersenen zien en van deze informatie een beeld reconstrueert. De onderzoekers kijken in feite met een fMRI naar hersenactiviteit, waarna ze wat de ogen zien met behulp van een diep neuraal netwerk (DNN) opnieuw creëren. Een DNN is een vorm van kunstmatige intelligentie (KI) die de werking van de hersenen nabootst.

Niemand dacht dat de algoritmen genoeg informatie zouden hebben om te reconstrueren wat een proefpersoon ziet – zonder de DNN eerst op miljoenen voorgeselecteerde afbeeldingen te trainen. De onderzoekers schrijven: “Directe training van een DNN met fMRI-gegevens wordt vaak vermeden omdat we denken dat het aantal beschikbare gegevens onvoldoende is om een complex netwerk met een grote hoeveelheid parameters te trainen”. Dit team heeft echter een ‘end-to-end’-oplossing gevonden waarmee de DNN toch in staat is om met maar 6.000 voorbeelden hersenactiviteit te lezen en beelden te reproduceren.

Tristan Greene rapporteert voor The Next Web: “De oude manier was iemand een aantal foto’s te laten zien en hem dan te vragen een inktvlek met gebruik van de foto’s te interpreteren. Nu gebruiken de onderzoekers gewoon de inktvlekken en moeten de computers raden wat deze vertegenwoordigen. In de praktijk betekent dit dat het nu mogelijk is om een DNN te leren fMRI-gegevens te interpreteren zonder toegang tot een enorme bibliotheek van beelden. Hierdoor wordt het proces vereenvoudigd en kan het in de praktijk gebruikt worden.

Hoe herdefinieer je hoe een diep neuraal netwerk ‘ziet’?

Een andere doorbraak op het gebied van gedachten omzetten in beelden was de nieuwe benadering van de manier waarop beeld-reproducerende DNNs werken. In plaats van te focussen op pixels, maakte Shen’s team een model van hoe onze eigen hersenen interpreteren wat we zien, gebruik makend van hiërarchie om uit te vinden wat belangrijk was. “Onze vorige methode was gebaseerd op de aanname dat een beeld uit pixels of eenvoudige vormen bestaat”, legt Kamitani uit. “Maar het is bekend dat onze hersenen visuele informatie hiërarchisch verwerken door verschillende niveaus van kenmerken of componenten van verschillende complexiteiten te extraheren”. Catherine Clifford rapporteert voor CNBC: “Dit betekent dit dat het nieuwe KI-onderzoek computers in staat stelt om objecten te detecteren, niet alleen binaire pixels”. Met andere woorden, de DNN van het team kan een object onderscheiden, niet alleen een patroon van vormen ‘zien’. Kamitani merkt op: “In tegenstelling tot eerdere methoden waren we nu in staat om door een persoon geproduceerde visuele beelden te reconstrueren door alleen maar te denken aan een aantal herinnerde beelden”. Dat is een verbluffende prestatie.

De nauwkeurigheid van het KI-systeem is verbazingwekkend en behoorlijk creepy

Shen’s team is niet het enige dat bezig is met dit soort onderzoek. Psychologen van de Universiteit van Toronto gebruiken bijvoorbeeld een vergelijkbaar systeem dat gegevens van een elektro-encefalogram (EEG) verzamelt om de gezichten te recreëren die proefpersonen hebben bekeken. James Felton, verslaggever voor IFLScience, omschrijft de nauwkeurigheid van dit KI-systeem als “verbazingwekkend en behoorlijk creepy“.

En de ontwikkelingen volgen elkaar in razend tempo op. Zo schrijft Adam Jezard in opdracht van het World Economic Forum: “Wetenschappers aan Carnegie Mellon University in de VS beweren dat ze een stap dichterbij echt gedachten lezen zijn gekomen. Ze gebruiken algoritmen om hersensignalen te decoderen die diepere gedachten identificeren, zoals ‘de jonge auteur sprak met de redacteur’ en ‘de overstroming veroorzaakte waterschade in het ziekenhuis’. Volgens de onderzoekers is de technologie in staat om complexe gebeurtenissen – uitgedrukt in zinnen – en semantische kenmerken – zoals mensen, plaatsen en acties – te begrijpen om te voorspellen welke soorten gedachten worden overwogen”.

Privacyvoorstanders uiten hun bezorgdheid

Er is inderdaad geen twijfel over dat dit enorm belangrijke en ingrijpende ontwikkelingen zijn. Maar voorvechters van het recht op privacy maken zich zorgen. In tegenstelling tot de spraaktechnologie waar we het eerder over hadden, hebben deze ontwikkelingen potentiële verontrustende gevolgen. Zodra deze technologie geavanceerder wordt, zegt Tristan Greene van The Next Web, “zou het door overheidsinstanties gebruikt kunnen worden om iemands rechten te omzeilen. In de VS betekent dit dat het recht van een persoon om in een strafzaak niet ‘gedwongen te worden getuige tegen zichzelf te zijn’ niet langer van toepassing is”. En Adrian Nestor, één van de onderzoekers aan de University of Toronto, denkt dat hun beeldreconstructie-technologie “ook gebruikt kan worden voor het verzamelen van ooggetuigen informatie over potentiële verdachten, in plaats van mondelinge omschrijvingen waarmee een compositietekenaar vervolgens een tekening maakt”.

Dat is een zorgwekkend idee, zelfs als het voor goede doeleinden gebruikt zou worden. Jezard zegt: “Onderzoekers en overheden moeten nog uitleggen hoe zij ervoor kunnen zorgen dat deze technologieën de mensheid ten goede komen in plaats van dat we erdoor benadeeld worden”.